今回は巷で流行ってるアニメのダンス動画のように

実写の動画をアニメーション化を導入してみようと思います。

Stable Diffusion Web Uiを使ってmov2movという拡張機能を導入していきます。

【~目次~】

mov2movの仕組み

「mov2mov」という拡張機能をStableDiffionに導入することで

実写動画からAI動画を生成することが出来ます。

「mov2mov」はベースの動画を一度コマごと(静止画)の画像に変換して

そのあとから、再度つなぎ合わせることで動画のように見せるようです。

AI動画生成の注意点

AI動画を生成して、youtube、SNS等に動画をアップロードする場合

ベースの動画に著作権などの問題が発生する可能性があるので

むやみに他人の動画を使って動画生成することは危険です。

自身を取った動画をベースにする、または

動画の使用許可が得られているものに限るなど

使い方を限定的することをオススメします。

「mov2mov」の導入手順

導入手順としての大まかな手順は下記。

①拡張機能「ControlNet」のインストール

②拡張機能「mov2mov」のインストール

③「mov2mov」の初期設定

となります。

拡張機能ControlNetのインストール

まず、拡張機能の「ControlNet」をインストールをします。

「ControlNet」の機能としては

・同じ絵のまま、色だけ変更や絵柄だけの変更

・同じ絵のままポーズのみ変える

・同じキャラクターのまま違う画像を生成させる

などの機能です。

①StableDiffionWebUiを起動します。

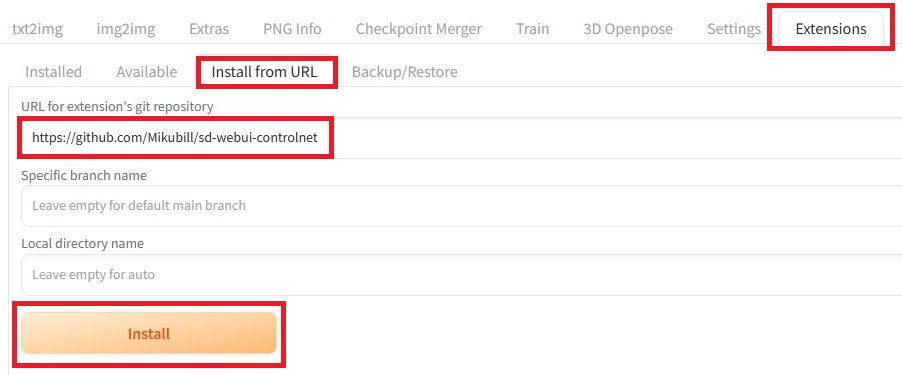

②画面の「Extensions」タブの、「Install from URL」をクリック。

③「URL for extension’s git repository」欄に書きのURLを入力する。

https://github.com/Mikubill/sd-webui-controlnet

④「Install」ボタンをクリックして、インストールを実行する。

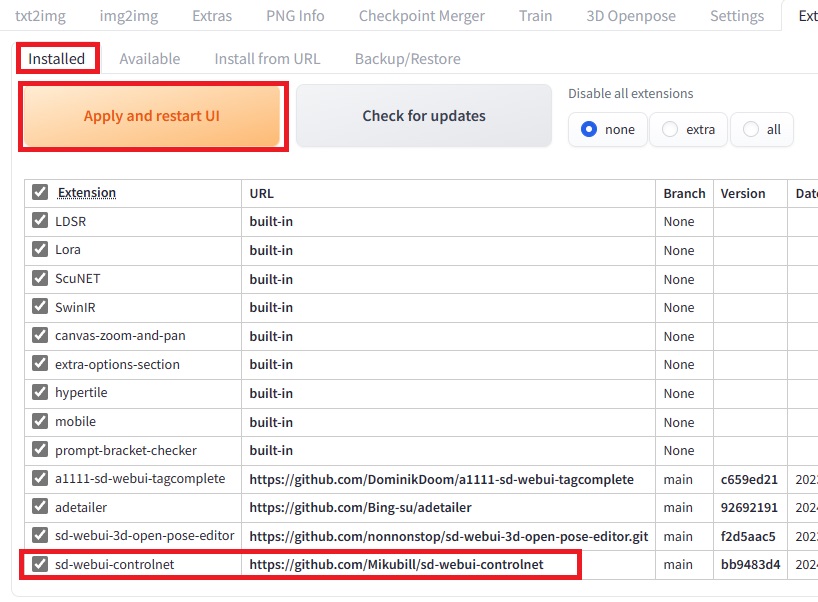

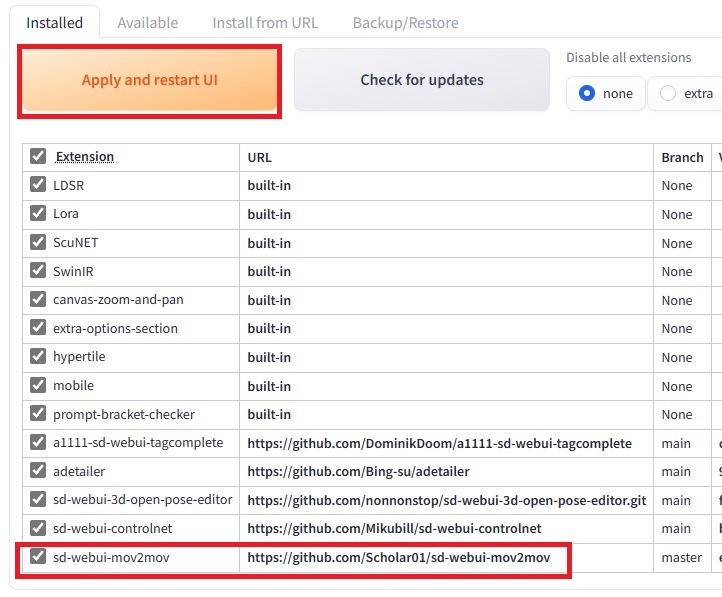

⑤「installed」タブをクリックすると、インストールすた拡張機能一覧が表示されます。

「sd-webui-controlnet」が一覧にあることを確認する。

⑥「Apply and restart UI」ボタンを押してStableDiffionを再起動します。

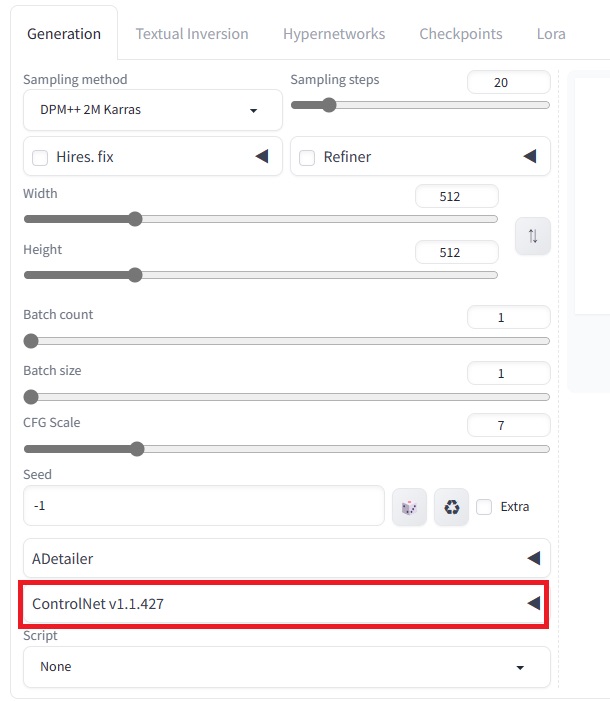

⑦StableDiffionが再起動すると、生成画面で「ControlNet」が

導入されてることが確認できます。

以上で、「ControlNet」の導入は完了です。

mov2movのインストール

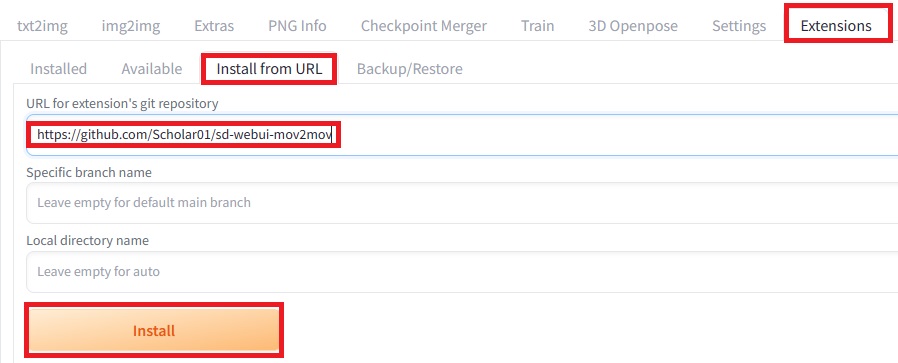

先ほどの「ControlNet」同様の手順で「mov2mov」をインストールします。

①「URL for extension’s git repository」欄に書きのURLを入力して「Install」をクリック。

https://github.com/Scholar01/sd-webui-mov2mov

②「Installed」タブで「sd-webui-mov2mov」があることを確認して

「Apply and restart UI」をクリックしてStableDiffionを再起動します。

以上でmov2movの導入および、有効化が完了です。

mov2movの初期設定

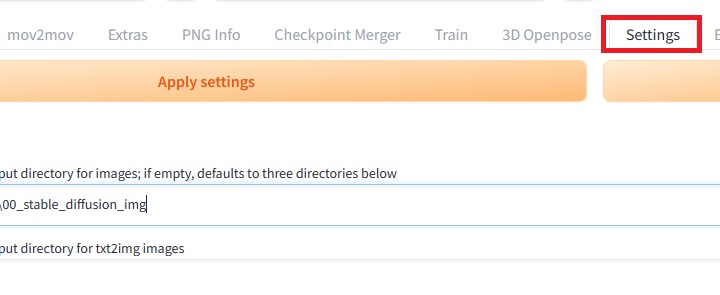

①StableDiffionの「Settings」タブを選択。

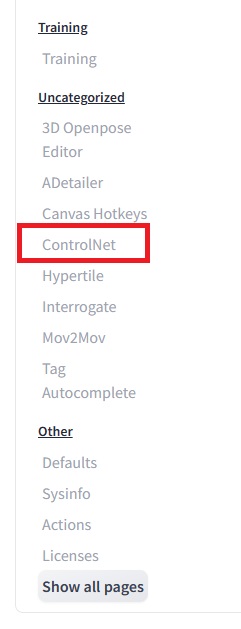

②画面左側より「ControlNet」を選択。

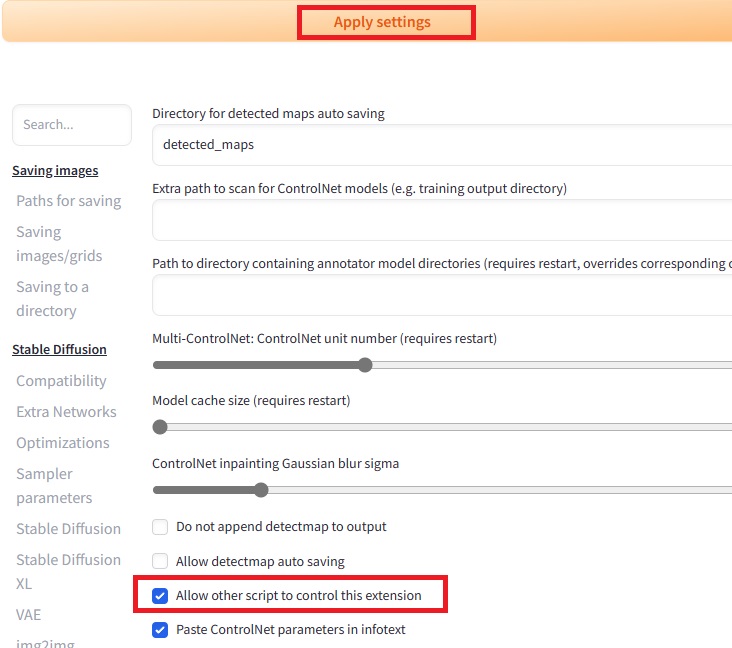

③「Allow other script to control this extension」にチェックを入れ、

「Apply settings」をクリック。

実際のアニメ動画生成してみよう

こんかいはお試しで、ロイヤリティーフリーの動画を

使ってアニメ化したいと思います。

アニメ化手順

①StableDiffionの「mov2mov」タブを開く。

②任意のプロンプトとネガティブプロンプトを入力する。

プロンプトには最低限として高品質化「best quality」などが必要です。

③生成元の動画をアップロードする。

その他の設定項目は

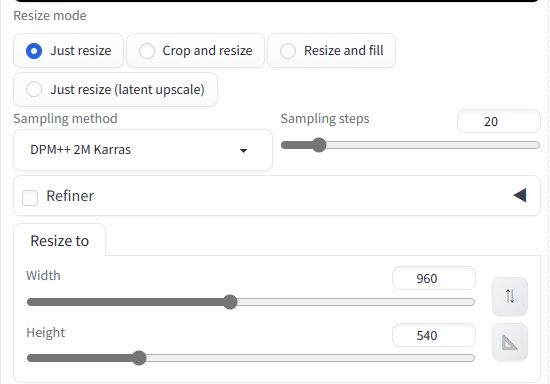

【Resize mode】

Just resize:元動画そのままサイズ変更

Crop and resize:一部を切り取ってサイズ変更

Resize and fill:サイズ変更し、一部追加

Just resize(latant upscale):元動画そのまま、画像拡大処理

基本的に、「Just resize」のままでOKかと。

「Resize to」で画像サイズを設定します。

「sampling method」は通常の画像生成と同様に

好きな設定を選択。

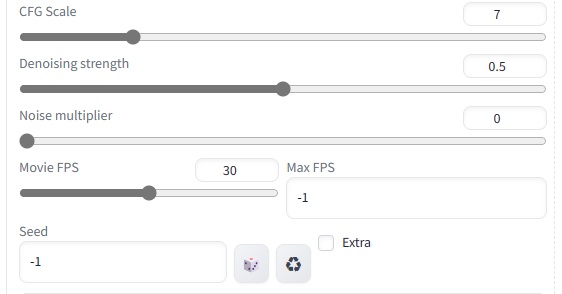

「Denoising strength」もお好みで。

数字が小さければ、元の動画に近く、大きければ変換が強くなります。

「Movie FPS」:お好みで。

フレーム数なので、多ければより滑らかになる分生成時間もかかります。

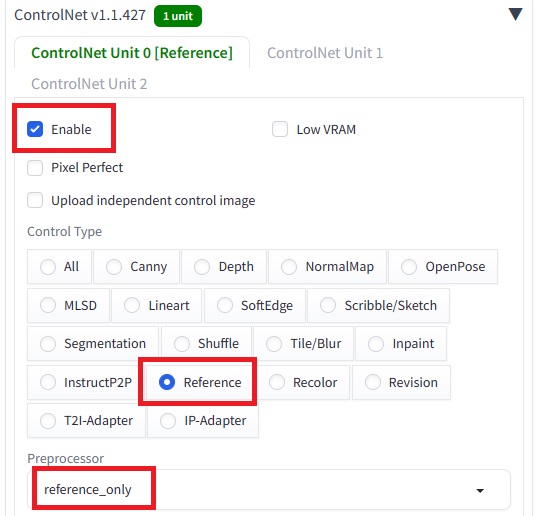

【ControlNet】設定

最後にControlNetのモデル設定を行います。

ココでのモデル設定でAI生成動画に大きく影響します。

「Enable」にチェックを入れる。

「Control Type」は生成動画に一貫性を持たせる場合

「Reference」や「OpenPose」がオススメ。

最後にStableDiffionの「Generate」ボタンで生成実行します。

mov2mov生成動画

下記がmov2movで生成した動画です。

生成動画には元動画の音声などは含まれないので、別途音声を当て込む必要があります。

短時間の生成でも時間を要するのと、データ容量が大きいと

エラーを起こすので、まだまだ改善の余地はありそうですが

なかなかおもしろいですよね👍

関連記事

-

【AI生成】AMDコスパPC構築

今回は最近はやりのAI生成を自分のPCでやってみたく。専用PCを自作しようと思います。 AI生成に必要最低限のスペック構 ...

続きを見る

-

【AI生成】Stable Diffusion web UIのPC環境構築手順

Stable DiffusionでAI画像を生成する方法は、WEBやクラウドでも可能ですが今回はAI生成マシンを組んだの ...

続きを見る

-

【Stablediffusionwebui】データ保存フォルダ変更やモデルの入れ替え方法

今回はStablediffusionWebuiの保存フォルダ先の変更やモデルの入れ替え方法をやってみようと思います。 S ...

続きを見る